流式导入

在ByteHouse中,您可以直接通过 Kafka 或 Confluent Cloud 流式传输数据。Kafka 数据导入任务将持续运行,读取 Topic 中的消息。ByteHouse 的 Kafka 任务可以保证 exactly once ,您的数据在消费后即可立即访问。

同时可以随时停止数据导入任务以减少资源使用,并在任何必要的时候恢复该任务。ByteHouse 将在内部记录 offset,以确保停止/恢复过程中不会丢失数据。

当前已经支持的 Kafka 消息格式为:

- JSON

- Protobuf

支持的 Kafka/Confluent Cloud 版本:0.10 及以上

创建流式导入任务

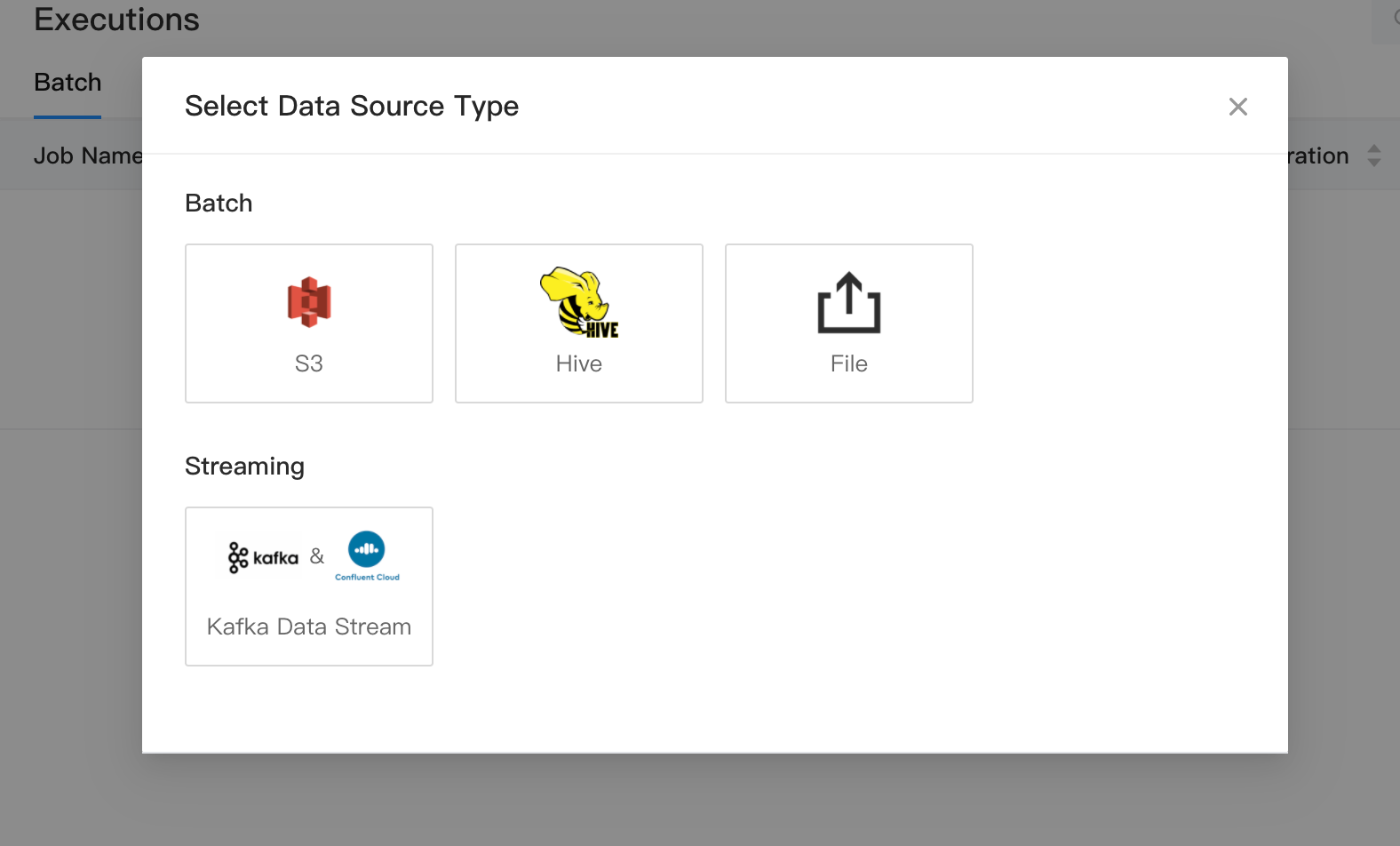

- 要创建 Kafka 导入任务,请前往加载数据并选择

Kafka 数据源。

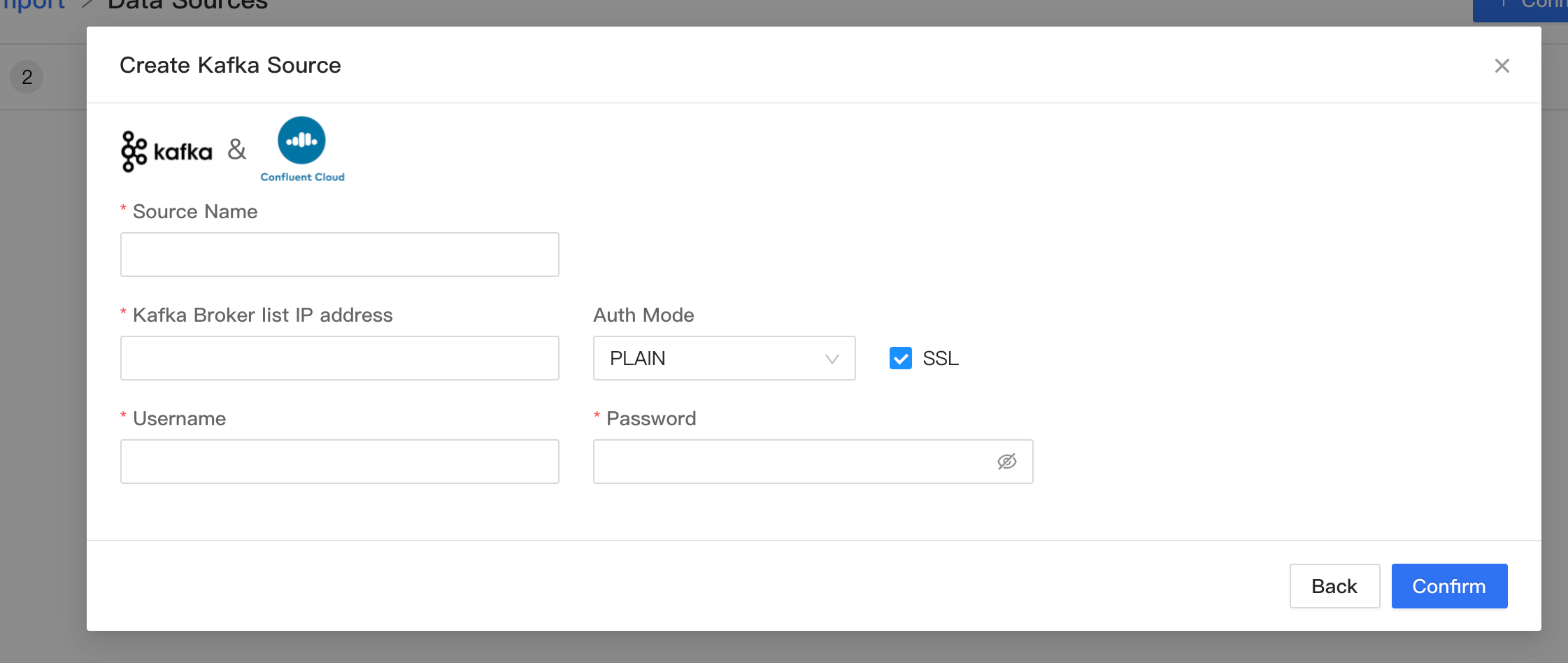

- 您可以选择已保存的连接信息,如果没有已存在的连接信息,您可以新建连接。当前 Kafka 数据源支持以下四种鉴权模式,并支持 SSL 加密:

- None 无鉴权

- PLAINTEXT 鉴权(支持 SSL)

- SCRAM-SHA-256(支持 SSL)

- SCRAM-SHA-512(支持 SSL)

您可以将任何需要的名称填入源名称中,并提供 broker 地址。您可以用逗号

,分隔。如果您的 Kafka需要身份验证,您可以选择授权模式并提供对应凭证。

-

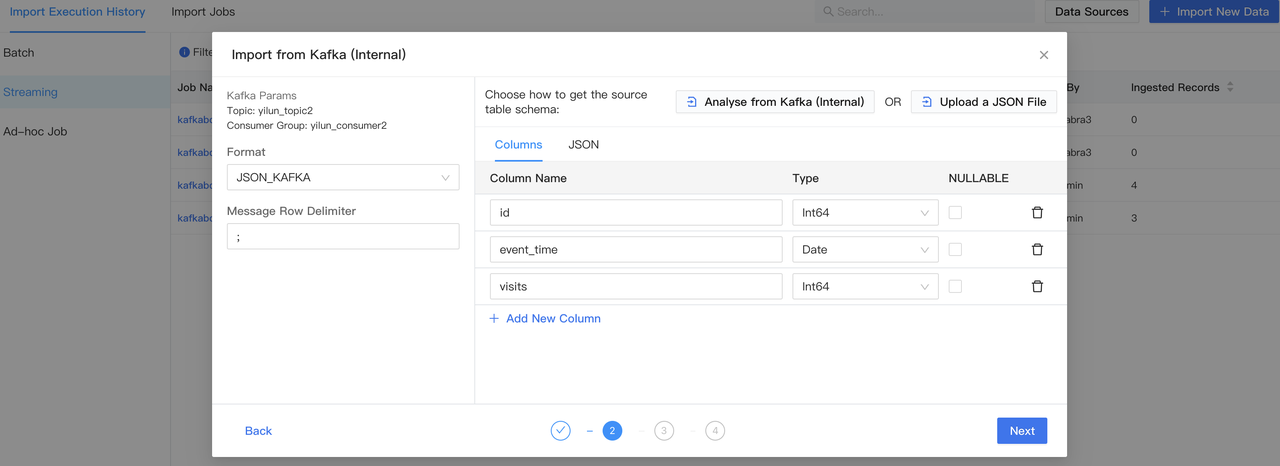

选择连接后,您可以进一步选择要加载的导入任务的 Topic。您可以选择为该 Topic 创建一个 Consumer Group。然后您可以指定已支持的消费格式。

-

通过 Topic Schema 解析

- 对于 JSON 格式,您可以通过指定分隔符来使用 Kafka 解析功能

- 对于 Protobuf 格式,您可以选择上传 JSON schema 文件

-

您可以为要加载的 Topic 选择一个表。首次使用时你可以基于解析的消息格式创建新表。

-

接下来,您可以命名此导入任务并添加描述。

- 导入任务一旦创建后将处于暂停状态。然后您就可以开始操作这项任务了。

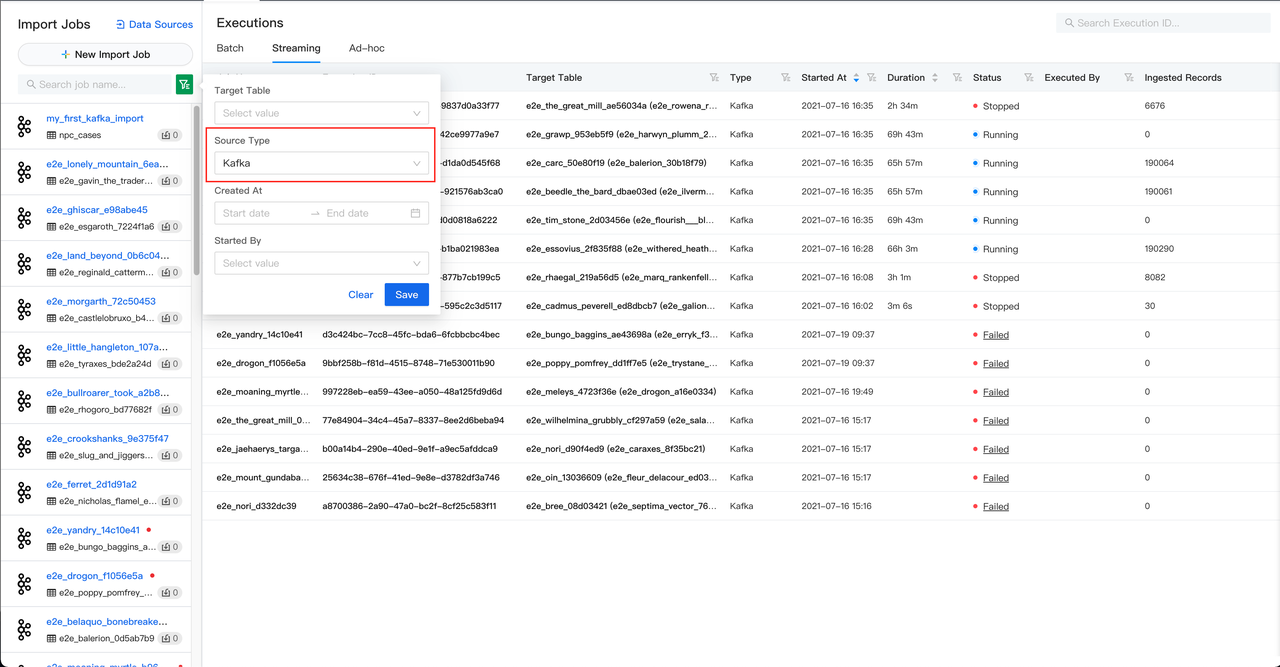

查看流式导入任务

在数据导入页面,您将看到所有类型的所有数据导入任务。您可以如下图所示过滤特定类型的任务:

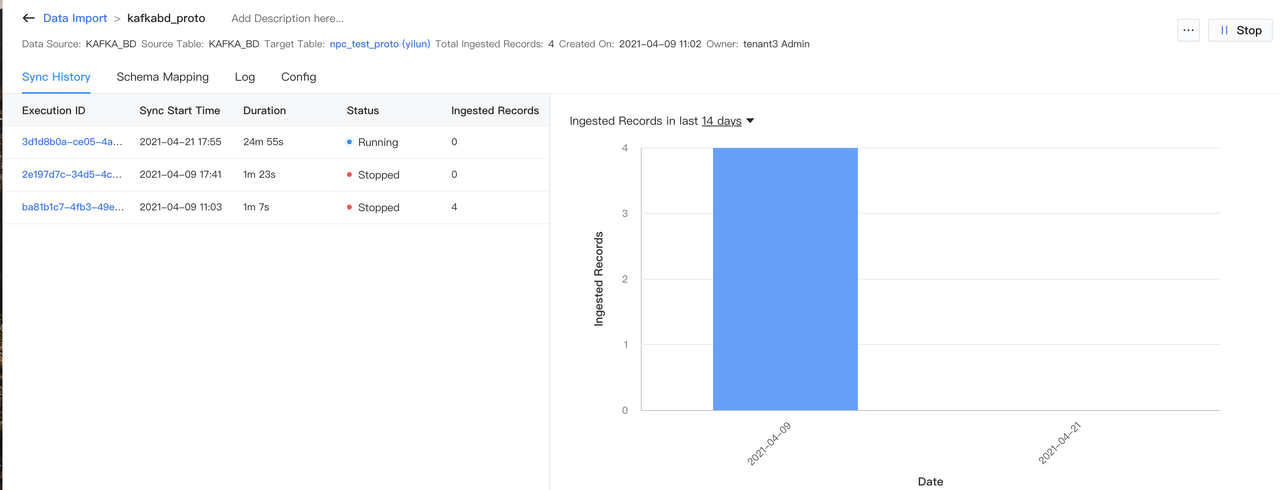

操作流式任务

- 启动流式导入任务,请进入流式任务页面,然后单击

开始

- 如果需要停止流式任务,请进入到流式任务页面内,然后点击

暂停

- 所有导入任务历史记录将保存在任务详细信息页面

Updated about 3 years ago